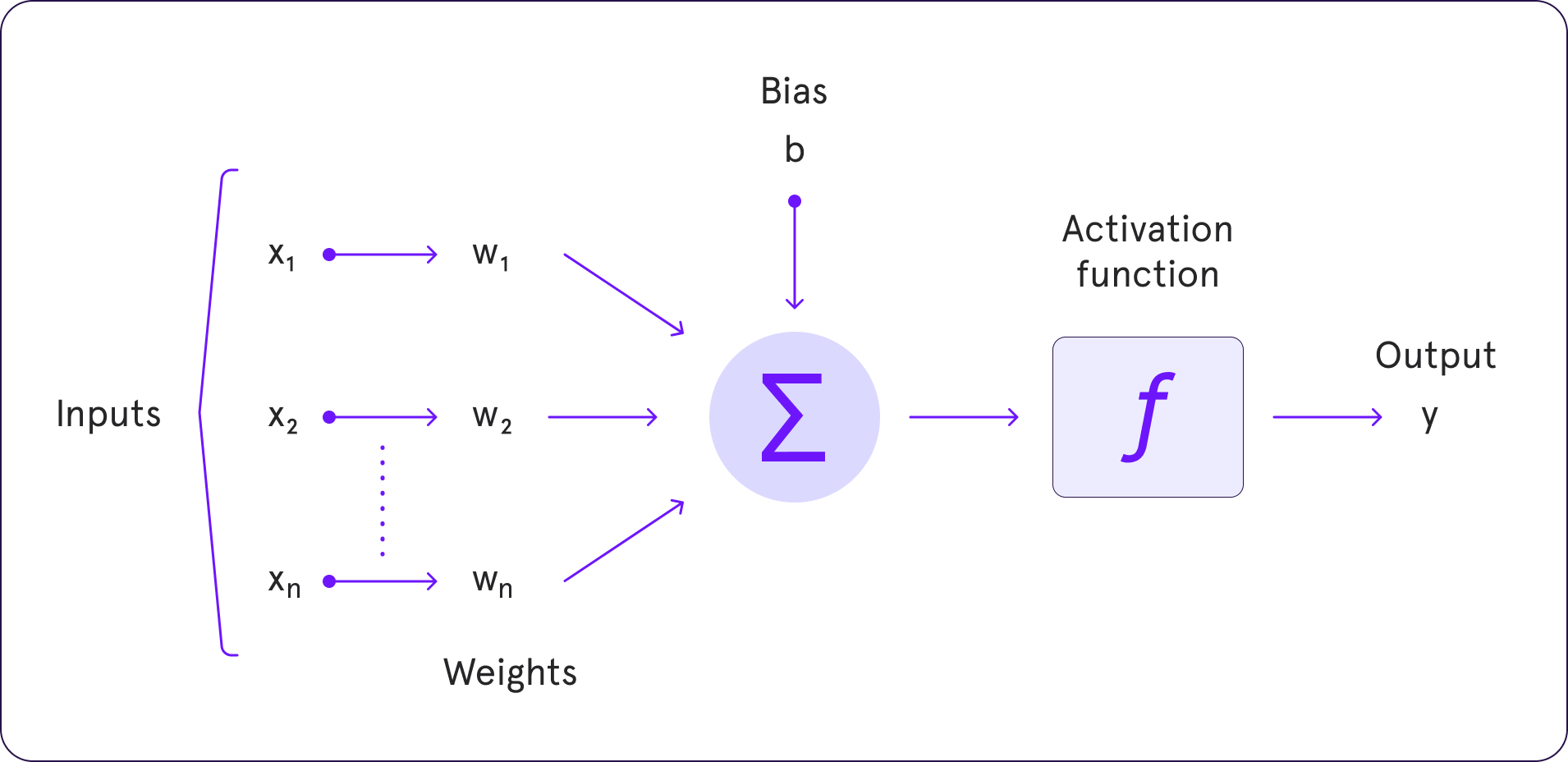

Deep Learning-д идэвхижүүлэлтийн функцүүд (activation functions) нь нейронуудын гаралтыг өөрчлөх буюу шилжүүлэх замаар нейрон сүлжээний сургалтын чадварыг сайжруулахад ашиглагддаг. Эдгээр функцүүд нь нейронуудаас гарч байгаа гаралтыг тодорхой хил хязгаар дотор хязгаарлаж өгдөг бөгөөд ингэснээр нейронуудын сургалтын процесс илүү тогтвортой болж, илүү нарийн мэдээлэл боловсруулах боломжийг олгодог.

Гол идэвхижүүлэлтийн функцүүд:

Sigmoid Function

- 0 ба 1-ийн хооронд гаралт гаргах бөгөөд гаралтыг логистик муруй хэлбэрээр үзүүлдэг. Гол асуудал нь өндөр болон бага утгуудын хувьд градиент ихээр багасах учраас сургалтын хурд багасдаг.

Tanh (Hyperbolic Tangent) Function

- -1 ба 1-ийн хооронд гаралт гаргана. Sigmoid функцтэй харьцуулахад төвлөрсөн утгад илүү нарийн мэдээлэл өгөх боломжтой. Гэхдээ градиентын устаж алдагдах асуудал хэвээр байна.

ReLU (Rectified Linear Unit) Function

- Тоон утгыг хэрэв эерэг байвал өөртэй нь тэнцүү, хэрэв сөрөг байвал 0 болгож өгнө. Илүү хурдан сургалтын хурдтай, гэхдээ “dead neurons” гэх асуудал үүсч болно, учир нь хэт их сөрөг утгатай нейронууд үргэлж 0 гаралт гаргах магадлалтай.

Leaky ReLU

- ReLU-ийн бага зэрэг өөрчлөгдсөн хувилбар. Сөрөг утгуудын хувьд бага зэрэг эерэг гаралт гаргадаг тул “dead neurons” асуудлыг багасгадаг.

Softmax Function

- Нийлбэр нь 1 байх олон ангиллын гаралтыг гаргадаг. Голчлон олон ангилалттай асуудлуудад ашиглагддаг бөгөөд хамгийн өндөр гаралттай ангилалыг сонгодог.