Оршил

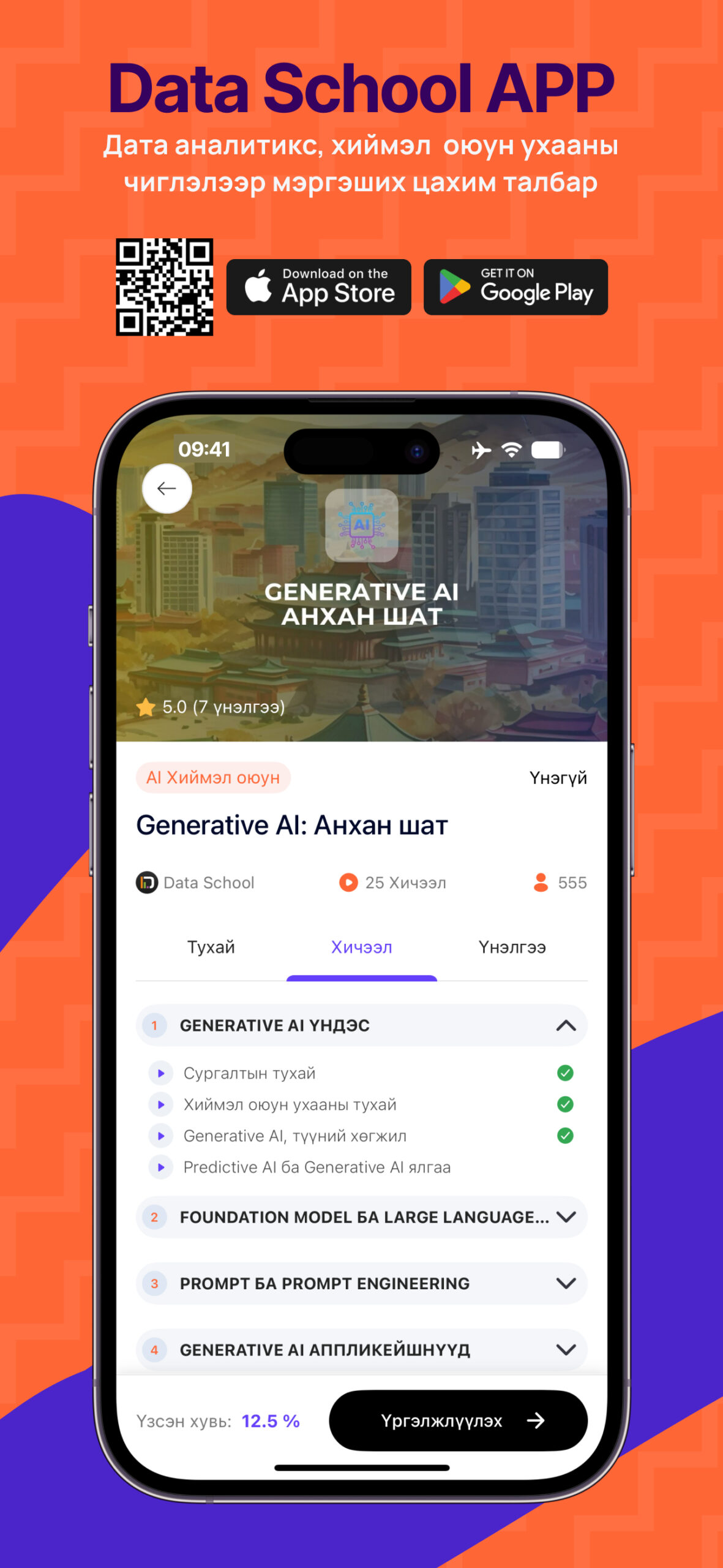

Сүүлийн жилүүдэд Хэлний Том Загварууд (LLMs) нь эх хэл боловсруулах (NLP) салбарт хувьсгал хийж, хүний түвшинд ойртсон гүйцэтгэл бүхий олон үйлдлийг автоматжуулахад амжилттай ашиглагдаж байна. Transformer архитектур, өндөр хүчин чадалтай тооцоолол, болон их хэмжээний сургалтын өгөгдөл дээр тулгуурлан эдгээр загварууд хурдацтай хөгжиж, хэл яриа ойлгох, үүсгэх, задлан шинжлэх, төлөвлөх зэрэг олон талт чадамжуудыг эзэмшжээ. Он цагийн дарааллын хувьд 2019 оноос гарсан загваруудыг доорх зурагт харуулав.

LLM-ийн үүсэл ба хөгжлийн үе шат

Эхэндээ хэлний загваруудыг зөвхөн тодорхой даалгаварт зориулж сургасан бол, орчин үеийн LLMs загварууд өөрсдөө даалгаврыг ерөнхийлөн ойлгож, цөөн жишээгээр (few-shot), эсвэл огт жишээгүйгээр (zero-shot) ч даалгавар биелүүлэх чадвартай болсон. Энэ нь GPT-3 загвараас хойш LLM-ийн хөгжлийн эрчимтэй үсрэлт болсон юм. Уламжлалт supervised сургалтыг орлох pre-training + fine-tuning хослол LLM-ийн суурь болсон.

Сургалтын архитектур ба стратеги

Том загваруудын хөгжлийг дэмжих үүднээс encoder-decoder, decoder-only, болон mixture-of-experts (MoE) архитектурууд өргөн хэрэглэгддэг болсон. Өгөгдлийн чанар, токенчлол, позицийн кодлолт зэрэг урьдчилсан боловсруулалт LLM-ийн үр дүнд онцгой нөлөөтэй. Мөн сургалтын хурдасгуур стратегиуд болох pipeline, tensor, model, optimizer parallelism зэрэг тархсан сургалтын хэлбэрүүд том загваруудыг сургахад шийдвэрлэх үүрэгтэй (Naveed et al., 2024).

Хэлний том загваруудыг сургах түгээмэл фрэймворкууд

LLMs хөгжүүлэх, сургах, ашиглахад өргөн хэрэглэгддэг гол программ хангамж, сангууд:

- Transformers: Төрөл бүрийн урьдчилан сургасан трансформер загваруудыг дэмждэг сан бөгөөд сургалт, fine-tuning, таамаглал хийх (inference), өөрийн загварыг хөгжүүлэх API-тай.

- DeepSpeed: Гүн сургалтын загваруудыг хуваарилсан орчинд (distributed) маш үр дүнтэй, өргөтгөх боломжтойгоор сургах, таамаглахад зориулагдсан сан.

- Megatron-LM: LLM загваруудыг GPU ашиглан том хэмжээтэйгээр оновчтой сургах арга техникүүдийг багтаасан сан.

- JAX: Өндөр хүчин чадалтай тоон тооцоолол болон өргөтгөх боломжтой машин сургалтын Python сан. Python болон NumPy функцуудыг ялган, GPU дээр гүйцэтгэх боломжтой.

- BMTrain: Том хэлний загваруудыг үр ашигтай, бие даасан байдлаар сургах код бичих боломж олгодог сан.

- FastMoE: PyTorch орчинд mixture-of-experts (MoE) төрлийн загваруудыг хялбар хөгжүүлэх API-тай.

- MindSpore: Гүн сургалтын сургалт ба таамаглал хийх зориулалттай платформ бөгөөд гар утас, edge төхөөрөмж, үүлэн тооцоололд өргөтгөж ашиглаж болдог.

- PyTorch: Facebook AI Research (FAIR) хөгжүүлсэн гүн сургалтын загвар боловсруулах framework.

- TensorFlow: Google-ээс бичигдсэн гүн сургалтын фрэймворк бөгөөд граф суурьтай тооцоолол, хурдан шалгаж гүйцэтгэх горим (eager execution), өргөтгөх боломжтой байдал зэрэг давуу талуудтай.

- MXNet: Apache MXNet нь олон хэл дээр (Python, C++, Scala, R гэх мэт) програм бичих боломжтой гүн сургалтын фрэймворк бөгөөд динамик болон статик тооцооллын графийг дэмждэг.

Fine-Tuning ба Alignment

Загваруудыг хэрэглэгчийн даалгаварт илүү тохируулахын тулд fine-tuning хийгддэг. Instruction-tuning аргачлал нь загварыг даалгаврын заавар болон оролт-гаралт хослол дээр сургаснаар, шинэ даалгавруудад илүү сайн хариулах чадвартай болгодог. Alignment-tuning нь LLM-ийг “тусч, үнэнч, хоргүй” (HHH) болгох зорилгоор reinforcement learning with human feedback (RLHF) ашиглан хүний хүсэл сонирхолд нийцүүлэхэд чиглэдэг.

Emergent Properties буюу гаралтын чадамжууд

LLM загварууд маш олон параметртэй болсноор reasoning, төлөвлөлт, in-context learning зэрэг даалгавраар тодорхой заагаагүй чадамжуудыг сурч эзэмшдэг болжээ. Chain-of-thought (CoT) prompting зэрэг техникүүдийг ашиглан LLM-ийг алхам алхмаар сэтгүүлж хариу гаргах чадвартай болгох нь эдгээр нууц чадамжийг илүү сайн ашиглах боломж олгож байна.

Олон талт хэрэглээ ба multimodal LLMs

LLM-ууд зөвхөн текст бус, дүрс, дуу, код гэх мэт олон төрлийн өгөгдөлтэй ажиллах multimodal чадвартай болж хөгжиж байна. Жишээ нь, Gemini, Claude, GPT-4o зэрэг загварууд нь дүрс, бичлэг, дуу зэрэг оролттой ажиллах чадвартай болжээ. Мөн LLM-powered агентууд нь олон даалгаврыг автоматжуулах, асуудал шийдвэрлэх чадамжтай болж хөгжсөн.

Үр ашигтай ашиглалт ба оновчлол

LLM-уудын сургалт, inference нь асар их зардал, нөөц шаарддаг. Иймээс quantization, pruning, knowledge distillation, parameter-efficient fine-tuning зэрэг аргуудаар LLM-ийг хөнгөн, хурдан, зардал багатай байлгах судалгаа эрчимтэй хийгдэж байна. Flash attention, grouped-query attention зэрэг архитектурын сайжруулалт LLM-ийн inference-ийг хурдасгаж чаджээ.

Чухал загварууд ба тэдгээрийн үр дүн

Олон алдартай LLM загварууд (GPT-3, 4, PaLM, LLaMA, T5, Chinchilla, BLOOM, OPT, Codex, AlphaCode, Galactica гэх мэт) гарсан ба тус бүр нь тодорхой шинэчлэл, онцлогийг агуулж байна. Тухайлбал:

- Chinchilla: бага параметртэй ч их өгөгдлөөр сургах нь үр дүнтэй болохыг харуулсан.

- LLaMA: Meta компанийн хөгжүүлж буй нээлттэй эхийн загвар.

- PaLM: reasoning ба instruction-following чадвар сайжруулсан.

- CodeGen, Codex: код бичих чадвартай LLMs.

Шинэ чиг хандлага ба ирээдүйн сорилтууд

Том загваруудын ил тод байдал, ёс зүй, найдвартай байдал зэрэг асуудлууд анхаарлын төвд байна. LLM-ийн hallucination буюу худал мэдээлэл үүсгэх эрсдэл, сурсан мэдээллийг буруугаар ашиглах (data leakage), болон хүний сэтгэлзүйн нөлөөлөл зэргийг даван туулах шаардлагатай. Ирээдүйд LLM-ийг илүү:

- interpretable (тайлбарлаж болдог),

- зардал багатай,

- аюулгүй, ёс зүйтэй,

- мэдлэгээ шинэчилдэг болох шаардлагатай байна.

Дүгнэлт

LLM-ууд нь хэлний боловсруулалтын ирээдүйг тодорхойлохуйц технологи болж хөгжжээ. Гэсэн ч тэдний чадамжийг бүрэн дүүрэн ойлгож, ёс зүйтэйгээр хөгжүүлэх нь шинжлэх ухааны чухал сорилт болоод байна. Хурдтай хөгжиж буй энэ салбарт ойлголттой, шүүмжлэлтэй, системтэй хандлага хэрэгцээтэй бөгөөд энэхүү тойм нийтлэл нь LLM-ийн хөгжлийн бүтэн дүр зургийг өгөхийг зорьсон юм.

Ном зүй:

- Naveed, H., Khan, A. U., Qiu, S., Saqib, M., Anwar, S., Usman, M., Akhtar, N., Barnes, N., & Mian, A. (2024). A Comprehensive Overview of Large Language Models (arXiv:2307.06435). arXiv. https://doi.org/10.48550/arXiv.2307.06435

- Welcome Gemma 3: Google’s all new multimodal, multilingual, long context open LLM. https://huggingface.co/blog/gemma3